Geplante europäische Regulierung zur Künstlichen Intelligenz – was müssen Hersteller von Medizinprodukten beachten?

Geplante europäische Regulierung zur KI

Im europäischen Kontext existieren aktuell zwei Gesetzgebungsinitiativen für einen Rechtsrahmen im Zusammenhang mit KI-Systemen. Zum einen hat das Europäische Parlament am 20. Oktober 2020 eine Entschließung zur „Regelung der zivilrechtlichen Haftung beim Einsatz künstlicher Intelligenz“ verabschiedet. Und zum anderen hat die Europäische Kommission am 21. April 2021 den weltweit ersten Entwurf eines Rechtsrahmens für Künstliche Intelligenz1 (KI) vorgelegt. Nach den Worten von Exekutiv-Vizepräsidentin Margrethe Vestager soll „mit diesen wegweisenden Vorschriften die EU an vorderster Front bei der Entwicklung neuer weltweiter Normen stehen, die sicherstellen sollen, dass KI vertrauenswürdig ist“.2

Dies gibt Anlass, den haftungsrechtlichen Status quo mit den geplanten Neuregelungen in Bezug auf Medizinprodukte zu vergleichen.

I. Status quo im Haftungsrecht für Medizinprodukte

In der Medical Device Regulation (MDR) (VO EU 2017/745) finden sich – mit Ausnahme des Art. 11 Abs. 5 MDR, der die gesamtschuldnerische Haftung des Bevollmächtigten3 und des Herstellers regelt – keine Haftungsregelungen. Vielmehr muss man auf die allgemeinen Regelungen der Produkthaftungsrichtlinie der EU 85/374/EWG zurückgreifen, die in Deutschland durch das Produkthaftungsgesetz (ProdHaftG) umgesetzt wurden. Dort werden Konstruktionsfehler (Verstoß gegen technische Erkenntnisse bei der Herstellung), Fabrikationsfehler (Abweichungen von den Konstruktionsvorgaben für einzelne Produkte während der Herstellung), Instruktionsfehler (unzureichende Gebrauchsanweisung oder fehlende Warnung vor Gefahren) und sog. potenzielle Fehler (hohe Ausfallwahrscheinlichkeit bei einer Produktreihe) geregelt.

Daneben sieht das nationale Recht noch die deliktische Haftung des Herstellers im Rahmen der sog. Produzentenhaftung vor, welche eine schuldhafte Pflichtverletzung voraussetzt. Besteht eine vertragliche oder vorvertragliche Beziehung, so können auch aus dem Vertragsrecht Haftungsregelungen folgen.

II. Notwendigkeit einer besonderen Regelung für sog. KI-Produkte

Im Hinblick auf die Veränderungen, die durch den Einsatz von KI in der Medizintechnik eintreten, wurde durch verschiedene Fachgesellschaften über die Notwendigkeit der Neuregelung der Haftungsvorschriften diskutiert. Die Europäische Kommission betont in diesem Zusammenhang4, dass es unklar ist, ob die Produkthaftungsrichtlinie und somit auch das ProdHaftG auf bestimmte Arten von Mängeln, z. B. wenn diese auf Schwächen bei der Cybersicherheit des Produkts zurückzuführen sind, Anwendung findet. Zudem müssen bei der KI die nachstehenden spezifischen Risiken aufgefangen werden:

- Entscheidungsrisiko (KI passt sich der Umweltsituation an und verfügt bei der Wahl ihrer Handlungen über einen gewissen Entscheidungsspielraum),

- Risiken der Unvorhersehbarkeit und der fehlenden Nachvollziehbarkeit (Konsequenzen des Handelns der KI sind möglicherweise nicht immer voraussehbar und nur bedingt nachvollziehbar, da die Entscheidungen ohne menschlichen Einfluss getroffen werden),

- Weiterentwicklungsrisiko (mangelnde Nachvollziehbarkeit der von KI-Systemen getroffenen Entscheidungen für das weitere Handeln),

- Risiko der Vernetzung (Verarbeitung von Daten, welche das System selbst aufzeichnet oder durch Verknüpfung mit einem anderen System erhält. Dadurch entstehen Schwierigkeiten beim Kausalitätsnachweis und bei der Abschichtung der Verantwortungsbereiche).

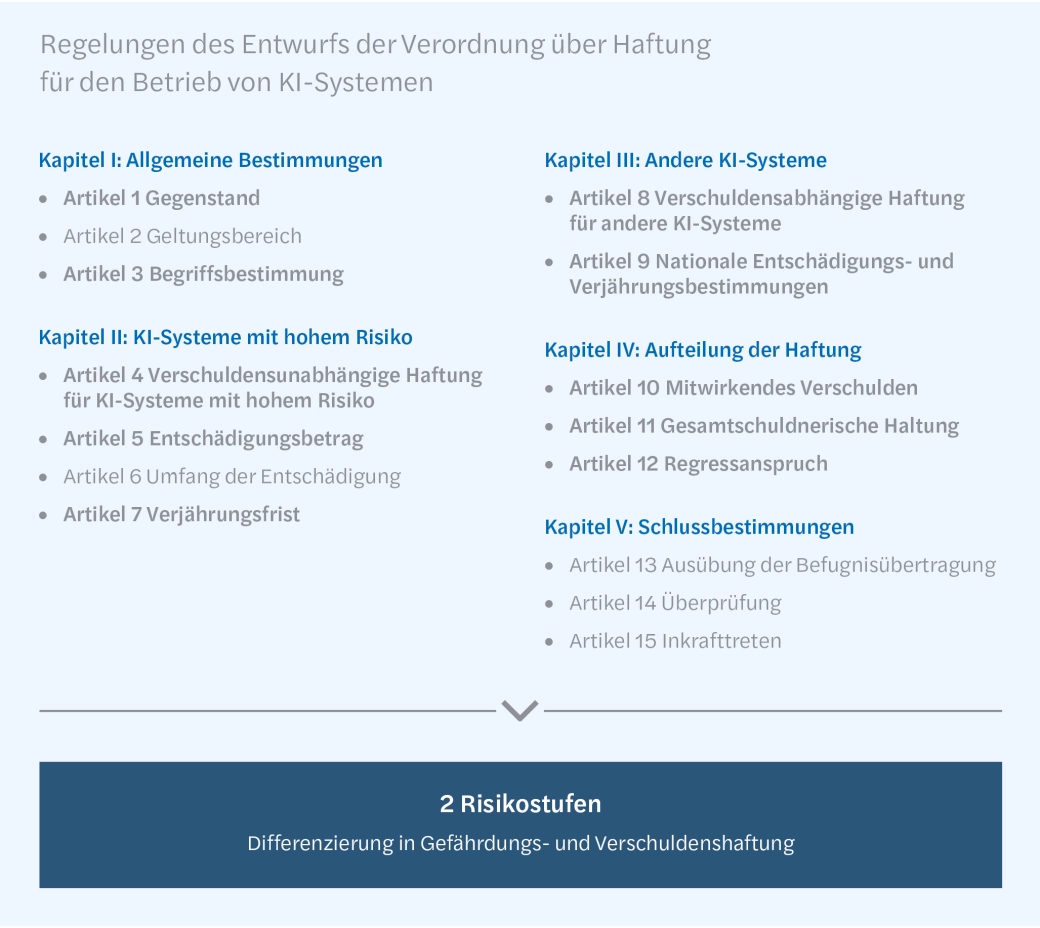

III. Entwurf der Verordnung über Haftung für den Betrieb von KI-Systemen vom 20. Oktober 2020

Die geplante Verordnung unterscheidet zwei Risikostufen, die wiederum eine Differenzierung in

Gefährdungs- und Verschuldenshaftung vorsehen.

1. KI-Systeme mit hohem Risiko – Gefährdungshaftung

Interessant sind vor allem die geplanten Regelungen des Kapitels II betreffend KI-Systeme mit hohem Risiko (Art. 4 bis Art. 7). Es wird hier die sog. Gefährdungshaftung geregelt, die eine verschuldensunabhängige Haftung für alle Personen- oder Sachschäden vorsieht, die von einer physischen oder virtuellen Aktivität, Vorrichtung oder einem Prozess des KI-Systems verursacht wurden. Der Betreiber hat keine Exkulpationsmöglichkeit bei der Einhaltung der gebührenden Sorgfalt, ein Haftungsausschluss soll nur bei höherer Gewalt möglich sein. Ferner sieht der Entwurf die Einführung einer Pflichthaftpflichtversicherung für den Betreiber sowie Haftungshöchstgrenzen und spezielle Verjährungsfristen vor.

Beachte: Grundsätzlich unterfallen nur die im Anhang der Verordnung genannten KI-Systeme der Gefährdungshaftung. Das Europäische Parlament erwägt jedoch eine Ausnahme hiervon. Ein System, das nicht im Anhang aufgeführt wird, soll dennoch der Gefährdungshaftung unterliegen, wenn es wiederholt Zwischenfälle verursacht hat, die schwerwiegende Personenoder Sachschäden nach sich gezogen haben.

2. Andere KI-Systeme – Haftung für vermutetes Verschulden

In Kapitel III wird für alle anderen KI-Systeme (Art. 8 bis Art. 9) eine Haftung für vermutetes Verschulden statuiert. Der Betreiber kann sich gem. Art. 8 Abs. 2 exkulpieren, wenn er nachweist, dass das System ohne seine Kenntnis aktiviert wurde oder dass – kumulativ – alle folgenden Maßnahmen mit gebührender Sorgfalt getroffen wurden: Auswahl eines geeigneten KI-Systems für eine Aufgabe, ordnungsgemäße Inbetriebnahme sowie Überwachung der Aktivitäten und Aufrechterhaltung der betrieblichen Zuverlässigkeit durch regelmäßiges Installieren aller verfügbaren Aktualisierungen.

Beachte: Im Hinblick auf die Anforderungen an die Exkulpation des Betreibers will das Europäische Parlament berücksichtigen, dass dem Betreiber die im KI-System verwendeten Daten nur begrenzt bekannt sein könnten (Erwägungsgrund 18). Insbesondere mit Blick auf die Auswahl eines geeigneten KI-Systems soll sich der Betreiber dann exkulpieren können, wenn er ein KI-System ausgewählt hat, das im Rahmen eines freiwilligen Zertifizierungssystems, vergleichbar mit dem von der KOM vorgeschlagenen „freiwilligen Gütesiegel“5 , zertifiziert wurde. In Deutschland wird bereits an der Entwicklung von Prüfverfahren für eine KI-Zertifizierung „Made in Germany“ gearbeitet.6

Sehr streng ist auch die geplante Regelung, die die Haftung des Betreibers selbst dann vorsieht, wenn der Schaden von einem Dritten verursacht wurde, der das KI-System in seiner Funktionsweise oder seinen Auswirkungen verändert hat und dieser nicht ausfindig gemacht werden kann oder zahlungsunfähig ist. Hier muss der Betreiber bestmöglich vorsorgen, um das Risiko zu mitigieren. Diese Vorsorge umfasst nicht nur das größtmögliche Wissen über das eingesetzte KI-System, sondern auch aktuelle Erkenntnisse über mögliche Angriffsszenarien (etwa sog. Data Poisoning Attacks).

Interessant ist auch die in Art. 8 Abs. 4 des Entwurfes festgelegte Kooperationspflicht des Herstellers, wonach er auf Aufforderung verpflichtet ist, mit Betreibern und Geschädigten zusammenzuarbeiten und ihnen Informationen bereitzustellen, um eine Haftungsfeststellung zu ermöglichen. Der Hersteller soll also an der Erforschung seiner eigenen Haftung aktiv mitwirken.

IV. Entwurf der Verordnung des Europäischen Parlaments und des Rates zur Festlegung harmonisierter Vorschriften für Künstliche Intelligenz (Gesetz über Künstliche Intelligenz) und zur Änderung bestimmter Rechtsakte der Union (KI-Verordnung) vom 21. April 2021

Die geplante KI-Verordnung verfolgt, ähnlich wie die MDR, den risikobasierten Ansatz und soll vier Risikostufen für die KI-Systeme einführen:

1. KI-Anwendungen mit inakzeptablem Risiko

… sollen verboten werden. Hierbei handelt es sich um Anwendungen, die Grundrechte verletzen, z. B. die Bewertung des sozialen Verhaltens durch Behörden (Social Scoring), die Ausnutzung der Schutzbedürftigkeit von Kindern, den Einsatz von Techniken zur unterschwelligen Beeinflussung und – mit eng gefassten Ausnahmen – biometrische Echtzeit- Fernidentifizierungssysteme, die zu Strafverfolgungszwecken im öffentlich zugänglichen Raum eingesetzt werden.

2. Hohes Risiko

KI-Anwendungen, die sich nachteilig auf die Sicherheit der Menschen oder ihre (durch die Charta der Grundrechte der Europäischen Union geschützten) Grundrechte auswirken, sollen gelistet werden. Nach dem Erwägungsgrund 30 der geplanten Verordnung sollen Medizinprodukte, die ein Konformitätsbewertungsverfahren unter der Beteiligung einer Benannten Stelle durchgeführt haben und KI-Anwendungen aufweisen, in die hohe Risikoklasse eingestuft werden. Dabei soll es sich jedoch um keinen Automatismus handeln, wie Erwägungsgrund 31 festlegt. Entscheidend soll stets die Funktionalität der KI-Anwendung sein.

Die Anbieter von Hochrisiko-KI-Systemen sollen folgende wesentliche Pflichten treffen:

- Durchführung eines Konformitätsbewertungsverfahrens zum Nachweis der Vertrauenswürdigkeit der KI (z. B. in Bezug auf Datenqualität, Dokumentation und Rückverfolgbarkeit, Transparenz, menschliche Aufsicht, Genauigkeit und Robustheit),

- Einbeziehung von unabhängigen Benannten Stellen,

- Einführung eines Qualitäts- und Risikosystems,

- Etablierung eines Beobachtungssystems zur Überwachung nach dem Inverkehrbringen, inkl. Meldung von schwerwiegenden Vorfällen oder Grundrechtsverstößen.

3. Geringes Risiko

KI-Anwendungen, bei denen eine klare Manipulationsgefahr besteht (z. B. durch den Einsatz von Chatbots). Diesen Systemen sollen generelle Transparenzverpflichtungen auferlegt werden.

4. Minimales Risiko

Auffangtatbestand für alle anderen KI-Anwendungen, der die große Mehrheit der KI-Systeme, die derzeit in der EU verwendet werden, betrifft. Anbieter solcher Systeme können freiwillig die Anforderungen an vertrauenswürdige KI anwenden und freiwillige Verhaltenskodizes einhalten.

Die geplante Verordnung sieht auch empfindliche Sanktionen bei Pflichtverletzungen vor. Dabei wird festgelegt, dass die Mitgliedstaaten wirksame, verhältnismäßige und abschreckende Sanktionen, einschließlich Geldbußen, festlegen und diese der Kommission mitteilen sollen. Die Europäische Kommission nennt allerdings bereits gewisse Schwellenwerte:

- bis zu 30 Mio. € oder 6 % des gesamten weltweiten Vorjahresumsatzes (je nachdem, welcher Wert höher ist) bei Verstößen durch verbotene Praktiken oder Verletzung von Datenanforderungen;

- bis zu 20 Mio. € oder 4 % des gesamten weltweiten Vorjahresumsatzes bei Verstößen gegen andere Anforderungen oder Verpflichtungen aus der Verordnung;

- bis zu 10 Mio. € oder 2 % des gesamten weltweiten Vorjahresumsatzes bei falschen, unvollständigen oder irreführenden Angaben in angeforderten Auskünften an Benannte Stellen und zuständige nationale Behörden.

Es sollen zudem Leitlinien ausgearbeitet werden, die der Harmonisierung der nationalen Vorschriften und Verfahren zum Ziel haben.

V. Fazit

Die Vorschläge zur Schaffung eines Rechtsrahmens für KI-Systeme sind begrüßenswert, bedürfen aber bei näherer Betrachtung noch einer Anpassung. Für Medizinprodukte ist insbesondere nicht klar, ob neben dem Konformitätsbewertungsverfahren nach der MDR ein zusätzliches Verfahren nach der KI-Verordnung durchgeführt werden muss. Eine Doppelbelastung sollte vermieden werden und die Konformitätsverfahren sollten harmonisiert werden. Zudem stellen sich auch bislang ungeklärte Fragen für bereits auf dem Markt befindliche KI-Systeme, insoweit sollten praxisgerechte Übergangsvorschriften geschaffen werden.

Die Entwürfe müssen noch in umfangreichen Verfahren debattiert und abgestimmt werden. Wir werden über die weiteren Entwicklungen berichten!

______________

1Entschließung des Europäischen Parlaments vom 20. Oktober 2020 mit Empfehlungen an die Kommission für eine

Regelung der zivilrechtlichen Haftung beim Einsatz Künstlicher Intelligenz (2020/ 2014(INL))

2Pressemitteilung der EU-Kommission vom 21. April 2021

3Allein aus Gründen der besseren Lesbarkeit wird auf die gleichzeitige Verwendung männlicher, weiblicher und diverser

Sprachformen verzichtet. Sämtliche Personenbezeichnungen gelten für alle Geschlechter.

4Vgl. Entschließung des Europäischen Parlaments vom 20. Oktober 2020 mit Empfehlungen an die Kommission für eine

Regelung der zivilrechtlichen Haftung beim Einsatz künstlicher Intelligenz (2020/2014(INL))

5Weißbuch zur Künstlichen Intelligenz – ein europäisches Konzept für Exzellenz und Vertrauen, COM (2020) 65 final/2, S. 29.

6Vgl. KI-Zertifizierung made in Germany

Haben Sie Fragen oder weiteren Informationsbedarf?

Autor*innen

Sebastian Cornelius Retter

Tel: +49 30 208 88 1043

Sonia Seubert

Tel: +49 30 208 88 1039

Dies ist ein Beitrag aus unserem Health-Care-Newsletter 3-2021. Die gesamte Ausgabe finden Sie hier. Sie können diesen Newsletter auch abonnieren und erhalten die aktuelle Ausgabe direkt zum Erscheinungstermin.

Kontakt